News

AI Kini Bisa Tipu Lewat Suara dan Video, OJK Imbau Masyarakat Lakukan Ini

Jakarta – Otoritas Jasa Keuangan (OJK) menyatakan kemajuan teknologi dalam Artificial Intelligence (AI) memiliki potensi penyalahgunaan membuat tiruan suara (voice cloning) dan tiruan wajah (deepfake) untuk menipu masyarakat.

Kepala Eksekutif Pengawas Perilaku Pelaku Usaha Jasa Keuangan, Edukasi dan Pelindungan Konsumen OJK, Friderica Widyasari Dewi, terkait dengan tiruan suara, teknologi AI memungkinkan pelaku untuk merekam dan meniru suara seseorang, seperti teman, kolega, atau keluarga.

“Dengan menggunakan suara yang sudah dipelajari tersebut, penipu dapat melakukan percakapan seolah-olah mereka adalah orang yang dikenal korban,” ucap Kiki dalam keterangan tertulis dikutip, 1 Agustus 2025.

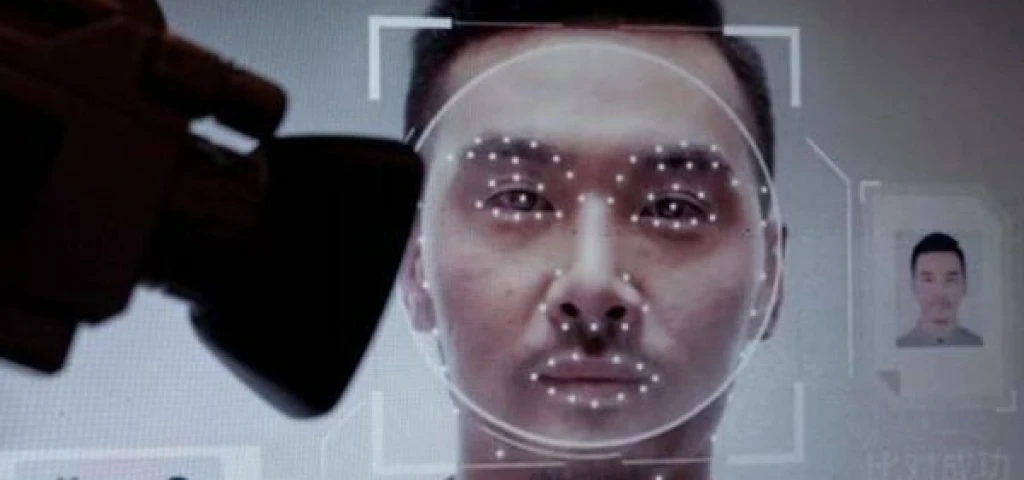

Sedangkan, AI pada tiruan wajah memungkinkan pelaku untuk membuat video palsu yang meniru wajah dan ekspresi seseorang dengan akurat.

Video ini dapat digunakan untuk meyakinkan korban bahwa mereka sedang berkomunikasi dengan orang yang mereka kenal sehingga korban merasa lebih percaya.

Oleh sebab itu, OJK mengimbau masyarakat untuk memperhatikan beberapa cara untuk mencegah penipuan AI antara lain:

• Verifikasi informasi, jika menerima permintaan yang tidak biasa, terutama yang meminta uang atau informasi pribadi, verifikasi terlebih dahulu dengan orang tersebut melalui saluran komunikasi yang lain

• Jaga kerahasiaan informasi pribadi, jangan pernah memberikan informasi pribadi atau keuangan kepada seseorang yang tidak dapat anda verifikasi dengan pasti identitasnya

• Hati-hati dengan video atau suara yang tidak biasanya, waspadai video atau suara yang terlihat atau terdengar tidak biasa meskipun datang dari orang yang dikenal. (*)

Editor: Galih Pratama

Kepala Eksekutif Pengawas Perilaku Pelaku Usaha Jasa Keuangan, Edukasi dan Pelindungan Konsumen OJK, Friderica Widyasari Dewi, terkait dengan tiruan suara, teknologi AI memungkinkan pelaku untuk merekam dan meniru suara seseorang, seperti teman, kolega, atau keluarga.

“Dengan menggunakan suara yang sudah dipelajari tersebut, penipu dapat melakukan percakapan seolah-olah mereka adalah orang yang dikenal korban,” ucap Kiki dalam keterangan tertulis dikutip, 1 Agustus 2025.

Sedangkan, AI pada tiruan wajah memungkinkan pelaku untuk membuat video palsu yang meniru wajah dan ekspresi seseorang dengan akurat.

Video ini dapat digunakan untuk meyakinkan korban bahwa mereka sedang berkomunikasi dengan orang yang mereka kenal sehingga korban merasa lebih percaya.

Oleh sebab itu, OJK mengimbau masyarakat untuk memperhatikan beberapa cara untuk mencegah penipuan AI antara lain:

• Verifikasi informasi, jika menerima permintaan yang tidak biasa, terutama yang meminta uang atau informasi pribadi, verifikasi terlebih dahulu dengan orang tersebut melalui saluran komunikasi yang lain

• Jaga kerahasiaan informasi pribadi, jangan pernah memberikan informasi pribadi atau keuangan kepada seseorang yang tidak dapat anda verifikasi dengan pasti identitasnya

• Hati-hati dengan video atau suara yang tidak biasanya, waspadai video atau suara yang terlihat atau terdengar tidak biasa meskipun datang dari orang yang dikenal. (*)

Editor: Galih Pratama